La tecnología de reconocimiento facial ha empezado a ser utilizada para la contención de enfermedades como el coronavirus.

Si una persona en el estado de Australia Occidental contrae covid-19, debe permanecer en cuarentena domiciliaria durante siete días, al igual que sus contactos cercanos.

La policía verifica su paradero mediante el envío de mensajes de texto periódicos y pide que envíen una selfie dentro de los siguientes 15 minutos.

La policía utiliza tecnología de reconocimiento facial y seguimiento por GPS para determinar si la persona que se tomó la selfie está en casa. Si no está, rápidamente llegan tocando en la puerta con una multa potencialmente considerable.

La aplicación G2G de la empresa emergente local de tecnología Genvis ha sido utilizada por más de 150.000 personas en el estado desde que se lanzó en septiembre de 2020.

La misma tecnología, aunque proporcionada por diferentes empresas, se ha probado en los estados de Nueva Gales del Sur, Victoria, Australia Meridional y Tasmania.

Australia se destaca como la única democracia que utiliza tecnología de reconocimiento facial para ayudar en los procedimientos de contención de la covid-19, mientras que otros países rechazan la idea.

San Francisco fue la primera ciudad de EE.UU. que introdujo una moratoria contra el uso de reconocimiento facial por parte de la policía en mayo de 2019. Le siguieron rápidamente Oakland, también en California, y Somerville, en Massachusetts.

Amazon, Microsoft, IBM y Google declararon que no venderán sus algoritmos de reconocimiento facial a las fuerzas de seguridad hasta que exista una ley federal.

En noviembre de 2021, Facebook anunció que eliminaría 1.000 millones de “huellas faciales” y dejaría de usar la tecnología para etiquetar a personas en fotos.

La Comisión Australiana de Derechos Humanos pidió una moratoria sobre la tecnología hasta que Australia tenga una ley específica para regular su uso.

Los activistas de derechos humanos dicen que existe la posibilidad de que los datos personales obtenidos se utilicen para fines secundarios, y que es una pendiente resbaladiza hasta convertirse en un Estado de vigilancia.

Grupos como Amnistía Internacional advierten que el uso del reconocimiento facial conduce a la discriminación racial.

“La pandemia creó todas estas nuevas justificaciones para usar la tecnología de reconocimiento facial”, señala Mark Andrejevic, profesor de estudios de medios en la Universidad de Monash, en Melbourne, y autor de un libro de próxima publicación titulado “Facial Recognition” (Reconocimiento facial).

“Todo se puso en internet y las organizaciones estaban tratando de hacer que las cosas funcionaran muy rápido. Pero no se pensó en las implicaciones. ¿Queremos vivir en un mundo donde todo está renderizado y no hay espacios privados? Crea un nivel completamente nuevo de estrés que no conduce a una sociedad saludable”, asegura.

Se necesita dar el consentimiento para usar la aplicación G2G, y también se necesitó después de los incendios forestales del “verano negro” de Australia de 2020, cuando aquellos que perdieron sus documentos de identificación usaron el reconocimiento facial para obtener los pagos de ayuda por desastre que daba el gobierno.

Pero ha habido ocasiones en que la tecnología de reconocimiento facial se ha usado de forma encubierta.

En octubre de 2021 se descubrió que el grupo de tiendas de conveniencia 7-Eleven había violado la privacidad de sus clientes al recopilar huellas faciales de 1,6 millones de clientes australianos cuando completaron encuestas de satisfacción.

Las huellas faciales supuestamente se obtuvieron para obtener perfiles demográficos y evitar que el personal alterara las encuestas aumentando sus calificaciones. La empresa no fue multada.

El Departamento del Interior de Australia comenzó a crear una base de datos nacional de reconocimiento facial en 2016 y parece estar listo para implementarla. En enero, presentó una licitación para que una empresa “construya e implemente” los datos.

“El reconocimiento facial está en la cúspide de un despliegue relativamente generalizado”, dice Andrejevic.

“Australia se está preparando para usar el reconocimiento facial para permitir el acceso a los servicios gubernamentales. Y entre las agencias gubernamentales que tienen que aplicacar la ley, definitivamente hay un deseo de tener acceso a estas herramientas”.

La mayoría de los gobiernos estatales han proporcionado a la base de datos central las licencias de conducir de sus residentes, y la base de datos también almacena fotos de visas y pasaportes.

En 2019 se propuso una ley para regular la tecnología de reconocimiento facial, pero se archivó después de que una revisión de un comité parlamentario descubriera que carecía de protecciones de privacidad adecuadas.

Entre sus críticos más firmes estaba el entonces Comisionado de Derechos Humanos de Australia, Edward Santow.

“Ahora nos encontramos en la peor de todas las situaciones, ya que no existe una ley específica, por lo que nos enfrentamos a algunas protecciones parciales que no son completamente efectivas y ciertamente no son integrales”, afirma Santow.

“Y, sin embargo, la tecnología continúa desplegándose”.

Santow está trabajando, con su equipo de la Universidad de Tecnología de Sydney, en formas de hacer que las disposiciones sobre privacidad sean más sólidas,

Una respuesta mundial variada

Parte del proyecto consiste en examinar los intentos de otros países de regular las tecnologías de reconocimiento facial.

Hay enfoques marcadamente diferentes en todo el mundo. Lo más común es confiar en un puñado de protecciones de privacidad limitadas que, según Santow, no abordan adecuadamente el problema; ese es el caso en Australia.

“Ningún país del mundo lo ha hecho bien”, señala Santow. “Si [las protecciones de privacidad fueran adecuadas], este proyecto sería realmente simple”.

Leila Nashashibi es una activista del grupo de defensa Fight for the Future, con sede en EE.UU., que trabaja para lograr una prohibición federal del reconocimiento facial y otros identificadores biométricos.

“Al igual que la energía nuclear y las armas biológicas, el reconocimiento facial representa una amenaza para la sociedad y nuestras libertades básicas que supera con creces cualquier beneficio potencial”, dice.

“El reconocimiento facial es diferente a cualquier otra forma de vigilancia porque permite el monitoreo automatizado y ubicuo de poblaciones enteras, y puede ser casi imposible de evitar. A medida que se propaga, la gente tendrá demasiado miedo de participar en movimientos sociales y manifestaciones políticas. La libertad de expresión se enfriará”.

En busca de huellas faciales en las redes sociales

El proveedor de tecnología de reconocimiento facial más prominente, la empresa estadounidense Clearview AI, parece no desanimarse por las demandas y las cuantiosas multas que está acumulando en una variedad de jurisdicciones.

Primero la tecnología atrajo la atención de los medios cuando un multimillonario la usó para identificar a la persona que iba a cenar con su hija, y actualmente el gobierno ucraniano la está usando para identificar a los soldados rusos muertos.

Sus familias son notificadas a través de las redes sociales, y las fotos a veces se envían como archivo adjunto.

También está intentando que su tecnología se use en las escuelas de Estados Unidos como un “sistema de gestión de visitantes”, el cual creen que podría usarse para ayudar a prevenir tiroteos al reconocer las caras de los estudiantes expulsados, por ejemplo.

La tecnología de reconocimiento facial y de objetos ya ha sido probada en varias escuelas por diferentes proveedores, incluido el reconocimiento de objetos que podría identificar un arma oculta.

“Clearview AI está explotando el terror y el trauma de las personas al decir que la vigilancia y el mantenimiento del orden son la respuesta”, afirma Nashashibi.

El director ejecutivo y fundador australiano de Clearview AI, Hoan Ton-That, no está de acuerdo.

Dice que la tecnología de reconocimiento facial tiene un gran potencial para la prevención del crimen, porque puede garantizar que solo las personas autorizadas tengan acceso a un edificio como una escuela.

“Hemos visto que nuestra tecnología se usa con gran éxito por parte de las fuerzas del orden público para detener el tráfico de armas, y tenemos la esperanza de que nuestra tecnología se pueda usar para ayudar a prevenir crímenes trágicos con armas en el futuro”, asegura.

En Australia, la tecnología de reconocimiento facial se está utilizando en varios estadios para evitar que entren sospechosos de terrorismo o hooligans del fútbol que han sido vetados.

Andrejevic cree que el uso del reconocimiento facial como medida de seguridad es un paso importante en la vigilancia y requiere una cuidadosa consideración.

“Las cámaras a menudo son criticadas porque solo ofrecen evidencias después del hecho, mientras que el reconocimiento facial crea información procesable en tiempo real para prevenir el crimen”, afirma. “Esa es una concepción muy diferente de la seguridad”.

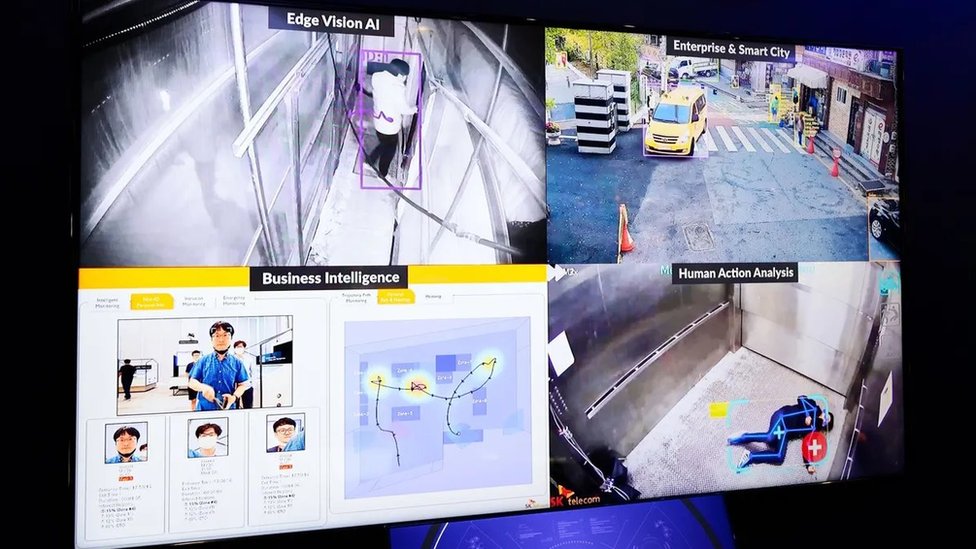

Algunas fuerzas policiales de todo el mundo ya utilizan el reconocimiento facial en vivo.

La Policía Metropolitana de Londres, por ejemplo, lo usa para monitorear áreas específicas en busca de delicuentes buscados o personas que podrían representar un riesgo para el público.

Clearview ha creado una base de datos de búsqueda de 20.000 millones de imágenes faciales, en gran parte extrayendo fotos de las redes sociales sin consentimiento.

Ton-That ha dicho que la compañía no trabajará con gobiernos autoritarios como China, Corea del Norte e Irán. Sin embargo, ha encontrado problemas en algunas democracias.

Fue prohibida en Canadá y Australia y el 24 de mayo, la Oficina del Comisionado de Información (ICO, por sus siglas en inglés) de Reino Unido la multó con más de US$9,1 millones luego de una investigación conjunta con la Oficina del Comisionado de Información de Australia.

Se le ordenó eliminar los datos de los residentes británicos de sus sistemas.

En diciembre de 2021, el organismo de control de la privacidad de Francia descubrió que Clearview infringió el Reglamento General de Protección de Datos (GDPR) de Europa.

Santow dice que el objetivo en Australia es desarrollar un enfoque matizado que fomente el uso de aplicaciones positivas e imponer límites para prevenir daños.

El peor de los casos sería replicar el sistema de “crédito social” de China, país cuyo gobierno rastrea a las personas y organizaciones para determinar su “confiabilidad”.

“Al determinar si un uso es beneficioso o dañino, nos referimos al marco básico internacional de derechos humanos que existe en casi todas las jurisdicciones del mundo”, señala Santow.

Por ejemplo, la ley exigiría el consentimiento libre e informado para utilizar el reconocimiento facial.

Sin embargo, si la tecnología provoca discriminación por su inexactitud en determinados grupos, el consentimiento sería irrelevante. Como dice Santow: “No puedes consentir que te discriminen”.

Cada vez más sofisticado y poderoso

“En los próximos dos años, vamos a ver un gran cambio en el uso de contraseñas, que son totalmente inseguras. La biometría se convertirá en la opción predeterminada”, dice O’Hara.

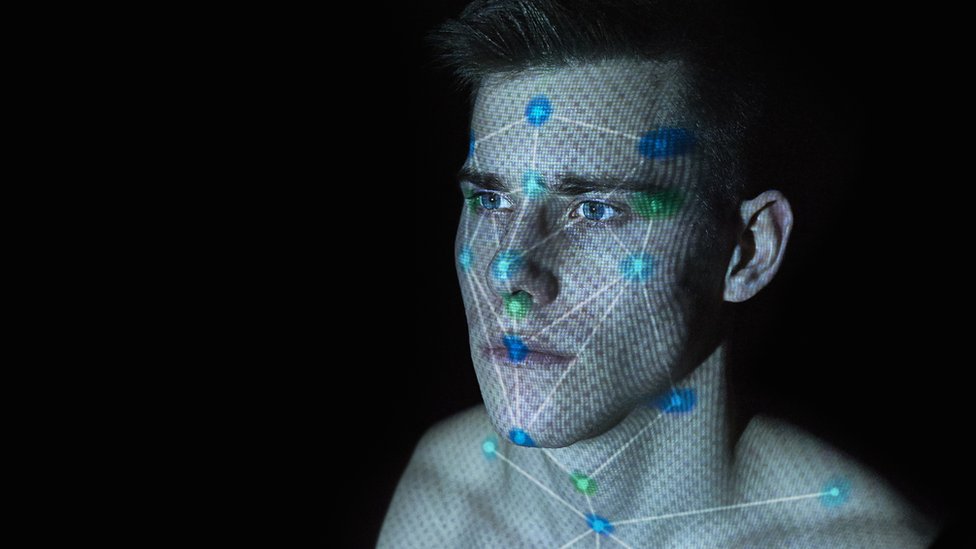

El reconocimiento facial funciona dividiendo el rostro en una serie de formas geométricas y mapeando las distancias entre sus “puntos de referencia”, como la nariz, los ojos y la boca.

Estas distancias se comparan con otras caras y se convierten en un código único llamado marcador biométrico.

“Cuando usas una aplicación de reconocimiento facial para abrir tu teléfono, no es una imagen de tu rostro lo que almacena tu teléfono”, explica Garrett O’Hara, de la empresa de seguridad Mimecast.

“Almacena una derivación algorítmica de lo que es tu cara matemáticamente. Parece un código largo de letras y números”.

El reconocimiento facial ha recorrido un largo camino desde que se desarrolló por primera vez en la década de 1960, aunque la tasa de error varía significativamente entre los diferentes sistemas que se utilizan en la actualidad.

Al principio, no podía distinguir entre hermanos o los cambios en el rostro de una persona a medida que envejecía.

Ahora es tan sofisticado que puede identificar a alguien que lleve una mascarilla o gafas de sol, y puede hacerlo a más de un kilómetro de distancia.

El mejor algoritmo de identificación de rostros tiene una tasa de error de solo el 0,08 %, según las pruebas del Instituto Nacional de Estándares y Tecnología de EE.UU.

Sin embargo, este nivel de precisión solo es posible en condiciones ideales, en las que los rasgos faciales son claros y despejados, la iluminación es buena y la persona está frente a la cámara.

La tasa de error para los individuos captados “al azar” puede llegar al 9,3%.

“Es una tecnología increíblemente útil. Pero si alguien nos hubiera preguntado hace 20 años, cuando arrancó el internet mundial, si queríamos vivir en un mundo en el que nuestras interacciones y actividades fueran recopiladas y rastreadas, la mayoría de nosotros probablemente habría dicho que sonaba espeluznante”, señala O’Hara.

“Ahora estamos replicando el seguimiento del espacio en línea para incluir también el espacio físico. Y no estamos haciendo las preguntas que deberíamos hacer”.

Uno de sus aspectos más problemáticos es su potencial para la discriminación racial y el sesgo.

La mayoría de las aplicaciones de reconocimiento facial se entrenaron inicialmente con conjuntos de datos que no eran representativos de la amplitud total de la comunidad.

“Al principio, los conjuntos de datos que se usaban se tomaban de todos de hombres blancos o personas blancas en general”, dice O’Hara.

“Y claramente, genera problemas cuando tienes personas de color o de diferentes etnias oantecedentes que no coinciden con los modelos de capacitación. Al final, son solo matemáticas. Este es el problema”.

Como resultado de esto, los sistemas de reconocimiento facial son propensos a cometer errores al intentar reconocer a personas pertenecientes a un grupo étnico minoritario, mujeres, personas con discapacidad y personas mayores.

Su uso ha resultado en arrestos falsos y otras consecuencias que alteran la vida de los afectados, señala Nashashibi.

Los “deepfakes” llevan el fraude a nuevas alturas

Ya sea una huella dactilar, un escaneo del iris, un análisis de la forma de caminar o una lectura capilar, ningún tipo de biometría es infalible.

A medida que la tecnología se vuelve más sofisticada, también mejoran los intentos de los piratas informáticos de manipularla para su propio beneficio.

Los “deepfakes” surgieron como una evolución de las técnicas de fraude, particularmente en relación con el reconocimiento facial digital (es decir, las fotos).

“Solía tomar varias horas crear un Deepfake usando herramientas de animación; ahora toma un par de minutos”, dice Francesco Cavalli, cofundador de Sensity AI, con sede en Ámsterdam.

“Todo lo que necesitas es una foto para crear un deepfake en 3D. Esto significa que los estafadores pueden escalar sus operaciones y los ataques se están disparando. Ni siquiera necesitas ser desarrollador o ingeniero. Puedes hacerlo tu mismo. Hay toneladas de aplicaciones que te permiten replicar la cara de cualquier persona”.

Sensity AI ayuda a gobiernos, institutos financieros e incluso sitios web de citas a detectar aplicaciones fraudulentas, ya sea para obtener pagos de ayuda por covid-19, almacenar dinero lavado en una cuenta bancaria o chantajear a alguien en Tinder.

La prueba de detección de caras con infrarrojo determina la temperatura corporal y el parpadeo cuando alguien toma una foto en internet, lo que significa que se detectará una foto de una persona “sintética”.

“En algún momento, los estafadores descubren cómo engañar a nuestros diferentes modelos, por lo que debemos idear nuevas técnicas continuamente”, dice.

A pesar de los desafíos en el camino hacia la regulación, Santow es optimista de que Australia pueda convertirse en un líder mundial en la regulación del reconocimiento facial.

“No puedo hablar en nombre de los gobiernos federal y estatales. Pero sé que entienden que existen fuertes preocupaciones de la comunidad y que es necesario generar confianza en la tecnología”.

“Australia podría proporcionar un buen modelo por varias razones”, agrega. “Tenemos un fuerte respeto institucional y corporativo de los derechos humanos. Puede que no sea perfecto, pero es fundamental para lo que somos como país. También somos un país innovador y desarrollador de tecnología”.

“Percibo que el mayor desafío no es redactar una ley infalible, sino asegurarse de que la ley en sí no sea ignorada”.